Los testing A/B son el arma más poderosa en manos del digital marketer, pero mal utilizados no sólo no sirven para nada sino que te llevan a caminos falsos en los que pierdes tiempo y dinero.

En los 20 años que llevo con el A/B testing, primero en marketing directo (mailings, revistas) y luego en online (emailings, landing pages, banners, etc.), si algo he aprendido es que:

Sólo hay una cosa peor que no hacer un test: hacer mal un test

Si ya cuesta convencer a un cliente de los beneficios de hacer un test A/B, sólo falta que después de dedicarle días o semanas, cientos de euros o miles, el resultado sea "ups, nos quedamos como estábamos".

Bueno, como estábamos no, con una oportunidad perdida y un agujero en finanzas.

Los tests A/B son una metodología científica, hay que seguir un proceso. Es algo muy serio como para hacerlo a la brava.

De lo contrario puedes cometer errores que lo invalidan. Los 4 más importantes y graves que he vivido en carnes propias y ajenas son:

- Testar dos cosas a la vez

- Tener resultados del test no significativos: muestra y azar

- Testar dos cosas que son la misma cosa

- Ignorar la jerarquía del A/B testing

1. Testar dos cosas a la vez

"¿Haces tests?, le pregunté.

"Sí claro, precisamente acabamos de hacer uno. El martes pasado enviamos el email A y esta semana lo compararemos con lo que haga el email B que se envía mañana".

El típico error de introducir sin darse cuenta una segunda variable que anula el test y lo convierte simplemente en el envío de dos emails diferentes en momentos diferentes. Si B consigue mejores resultados que A no puedes decir que B es mejor que A, porque ha podido ser debido a nuevos factores que están presentes esta semana pero no la anterior.

Puede que sea porque esta semana hacía más calor (era un email de helados), porque tu competidor esta semana no ha enviado promociones o porque Trump no la ha liado en Twitter y han subido las bolsas.

Sólo puedes cambiar una variable, el resto tiene que estar estable

Al añadir una nueva variable, la del tiempo, ya no es un test A/B. La semana anterior es diferente a la actual, luego A y B no están jugando en igualdad de condiciones.

En un test de emailing como el de este ejemplo, las dos versiones A y B se tienen que enviar a la vez, el mismo día y hora, a dos listas de registros homogéneas y si la diferencia entre A y B es, por ejemplo, el Asunto, el resto de elementos creativos deben ser EXACTAMENTE idénticos.

Es lo que se llama a veces como "ceteris paribus", un latinajo que quiere decir algo así como "el resto de variables se quedan bien quietas".

Sólo así podremos sacar la conclusion de que el asunto B es mejor al asunto A, enviar al resto de la base de datos el email B y tener la garantía plena de que estaremos enviando el mejor email.

¿Significa esto que no se pueden testar dos variables? No.

Existen los tests multivariable, que como dice su propio nombre, permiten testar más de una variable a la vez.

Pero son más complejos, requieren un software especial y cantidades muy grandes de bases de datos. Sólo al alcance de unas pocas empresas

En el 99% de los casos estaremos hablando de split test A/B, así que, para hacerlo fácil:

Sólo cambies una variable a la vez, o no tendrás un test

2. Tener resultados del test no significativos: muestra y azar

Imagínate que hoy es el día de las elecciones. El periodista se planta a la salida de un colegio electoral para averiguar qué está votando la gente y poder así hacer una previsión del partido ganador.

Sale un persona de votar y le pregunta. "Al partido Anti-taurino" responde. El segundo votante "A los Anti-taurinos". Una tercera persona, misma votación.

El periodista, con tres votos, se va corriendo a la sede del periódico y manda publicar a toda prisa: "Sorpresa: ¡los Anti-taurinos ganan las elecciones!"

¿Verdad que no tiene sentido proclamar un ganador con sólo 3 resultados por mucho que coincidan?

Muestras pequeñas invalidan el resultado del test

De la misma forma que una encuesta sobre las elecciones debe contar con un gran número de respuestas para poder sacar alguna conclusion fiable, en un test A/B debemos contar con un volumen de datos suficiente para asegurar que nos podemos creer el resultado.

Oh my God! Llegamos al punto que todos queremos evitar: las mates.

Lamentamos introducir aquí la necesaria intervención de las matemáticas, y más concretamente, la estadística como elemento fundamental de todo aquel que quiera hacer testing mínimamente serio.

La estadística nos ayudará a calcular el concepto de confianza estadística o fiabilidad estadística.

Este concepto va de 0% a 100% y nos informa de la probabilidad de que en el futuro, al repetir la prueba, se mantenga el mismo resultado. Es decir, es el grado de seguridad que tenemos con los resultados del test.

Por ejemplo, hacemos un test y sale que B gana a A, calculamos este parámetro y nos sale:

- Confianza estadística del 50%: nos está diciendo que B ganará en el 50% de los casos y en el otro 50% ganará B. Como tirar una moneda. No hay ganador.

- Confianza estadística del 75%: estamos algo más seguros, en 3 de cada 4 casos ganará B, pero sigue habiendo bastantes posibilidades de que gane A (el 25% restante)

- Confianza estadística del 95%: si repitiésemos el test 100 veces, hay una probabilidad de que en 95 casos gane B y sólo en 5 casos gane A.

La certeza absoluta no existe pero cuanto mayor sea el grado de confianza estadística, mayor es la seguridad de que uno es mejor que el otro.

Pero tienes que fijar un mínimo. Por debajo no hay test, por encima, bingo.

Muchas empresas con un 80% o un 90% dan por válido un test... Podrían estar cometiendo un grave error.

Aunque suene muy alto 80% o 90%, en realidad son valores insuficientes.

En el sector, la referencia es un 95% de confianza estadística

Esto del testing A/B es algo muy serio, para tomar decisiones hay que estar muy seguro de que los resultados son fiables.

Por este motivo se suele aceptar todo lo que tenga un 95% o más de confianza y rechazar lo que no llegue a este nivel.

¿Te parece que es un nivel exagerado impuesto por una banda de histéricos?

Si te parece demasiado, mira los niveles de referencia de los grandes:

Google y otros gigantes de internet sólo aceptan tests con un 99% o más de confianza estadística

Estas empresas tienen muy claro el valor del A/B testing pero también que no se la pueden jugar: por ello son tan exigentes y quieren una fiabilidad de casi el 100% en todo lo que descubren.

¿Y cómo se llegan a resultados tan seguros?

La primera vía lo hemos visto más arriba: con una muestra suficientemente grande.

El tamaño nos lo dirán los cálculos, pero no tienen que ser necesariamente de millones de clics, como las de Google. Simplemente la necesaria. Pueden ser cientos o miles de resultados, pero en cualquier caso, será un muestra mínima por debajo de la cual no podemos estar.

La segunda vía es la diferencia entre los resultados de A y B: cuanto más diferentes sean A y B, mucho antes alcanzaremos altos niveles de confianza estadística.

Con tests arriesgados, potentes, se asegura un buen resultado. Con tests conservadores, tímidos, no

3. Testar dos cosas que son la misma cosa

En AdWords hemos hecho tests en los que cambiando un "sencillo" por un "fácil" conseguíamos resultados diferentes, muy diferentes.

Pero lo habitual es que no sea así. O por lo menos, no en el largo plazo.

Con más frecuencia de la que nos gustaría nos encontramos con A/B testings en los que hay dos ideas enfrentadas, en apariencia diferentes y sin embargo, el mercado, con su sentencia inapelable, te dice: "pues para mí es la misma cosa".

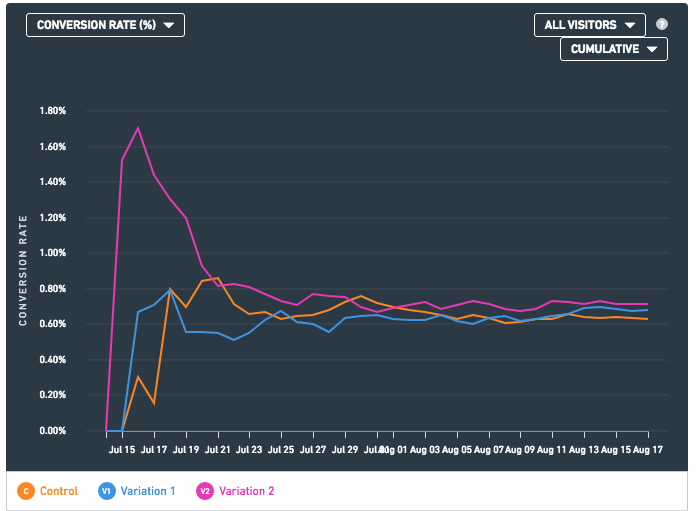

Por ejemplo, en la siguiente gráfica de un test, que no es un A/B sino un A/B/C ya que se testaron 3 variantes a la vez, se puede ver el desastre:

En este ejemplo se testó enviar los clics hacia tres posibles landing pages:

- Una landing larga

- Una landing corta

- La home del sitio web

Como puedes ver en el gráfico, el porcentaje de conversión al principio es muy variado, es normal cuando empiezas el test, pero a medida que se acumulan los resultados, las líneas se normalizan (por eso la importancia del tamaño de la muestra que hemos visto antes).

El problema es que la estabilización de los 3 colores se produce en los mismos niveles, se juntan las líneas, convergen en el mismo punto, incluso llegan a substituirse en la primera posición.

A medida que pasan los días, están cada vez más juntas y si lo dejásemos eternamente, llegarían a fusionarse.

Las tres opciones que parecían tan diferentes resultan ser, en la práctica, la misma cosa

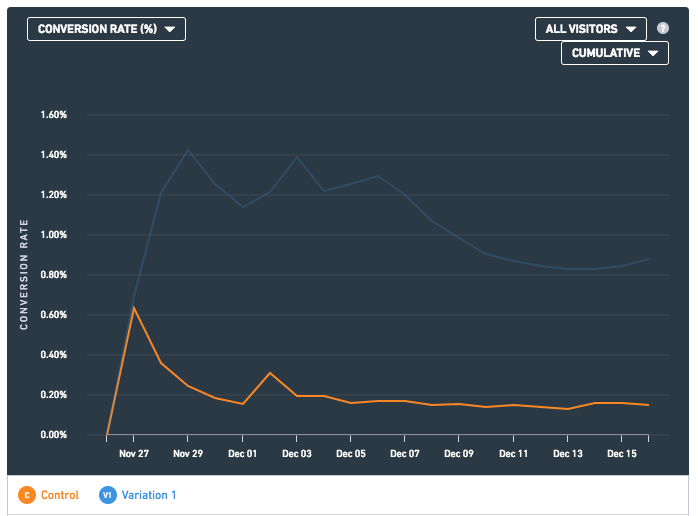

Ahora veamos un caso radicalmente opuesto.

Se trata de un test A/B también de landing pages, en el que la línea azul es la versión con más contenidos y la naranja una landing page con menor información.

En este caso, puedes ver que a los pocos días se marca una diferencia y que, lo más importante, con el paso del tiempo este salto se mantiene.

Cuando las gráficas se estabilizan se ve claramente que una gana sobre la otra. De hecho la diferencia es abismal, entorno a 4 veces más porcentaje de conversión entre la ganadora y la perdedora.

Un resultado tan aplastante que nos permitió acabar el test antes de lo previsto.

Las dos opciones eran bastante diferentes a simple vista, pero al probarlas, resultaron ser RADICALMENTE diferentes.

Aquí vemos el círculo virtuoso de hacer tests potentes: no sólo consigues mejorar a saltos sino que además acortas el tiempo del test, o lo que es lo mismo, reduces el tamaño de la muestra (gastas menos munición).

¿Qué tipos de tests hay que hacer entonces?

Si los resultados del tests te dicen que no hay un claro ganador, estás perdiendo tiempo y dinero. Para evitarlo, hay que asegurarse que en la fase de diseño se generan hipótesis y variables con suficiente potencial.

No hay reglas escritas para encontrar estas variantes. Ayuda la experiencia en muchos tests y el instinto. Pero sí podemos tener alguna ayuda. Por ejemplo, una buena pista es entender el siguiente error y no caer en él.

4. Ignorar la jerarquía del A/B testing

Hace un tiempo conocí a un director de marketing que estaba como loco con su primer A/B test. Era un test de emailing. Al cabo de 48 horas, como en la mayoría de los test de emialings, ya se habían recogido suficientes datos como para dar el veredicto.

Resultado: tanto A como B son lo mismo, la diferencia es mínima y no es representativa.

Vaya chasco. Le pregunté que me enseñase las dos variantes A/B.

A ver, a ver... Un test de botón (CTA) rojo contra botón naranja. ¡Mi madre!

No es la primera vez que me encuentro un tests de colores de botones. Es curioso como nos gusta probar este tema.

Tampoco tengo nada en contra de testar los colores de los botones, pero ¡siempre que antes hayas hecho los 3.000 tests que existen más importantes que el color del botón!

Los recursos son limitados, no podemos testarlo todo, hay que tener un plan

Si testamos sin orden, lo primero que se nos ocurra, lo que hemos visto que ha testado otro que "dice" que le ha ido muy bien, lo que nos parece fácil y rápido... tendremos todo los números para crear tests que no nos llevan a ningún lado.

En A/B testing, como en todo, la estrategia, la planificación, la metodología, es un 'must' si queremos tener éxito.

No todo los tests tienen el mismo potencial y por ello hay que empezar por los que tengan más visos de conseguir mejoras.

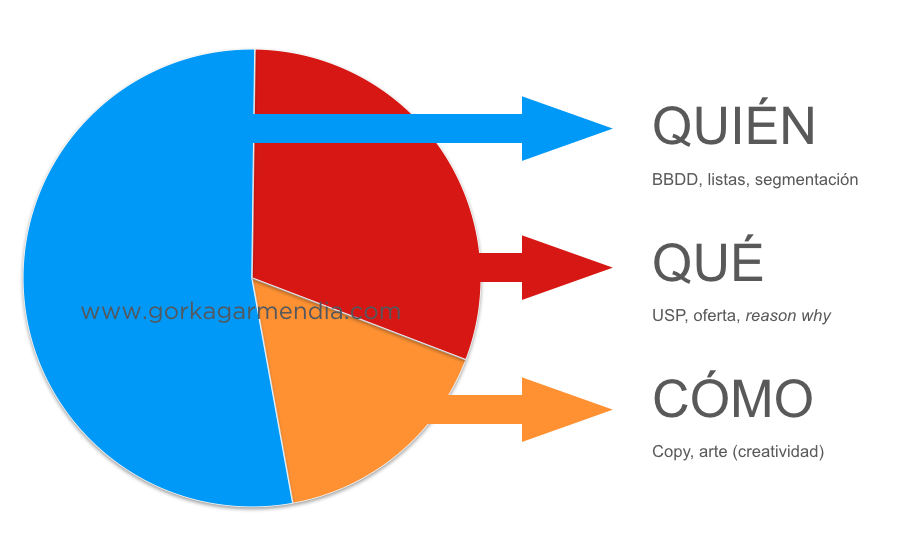

La jerarquía es clara y posiblemente ya me habrás oído hablar de ella en otras ocasiones. De más a menos se trata del QUIÉN, QUÉ y CÓMO.

Si el potencial de mejora fuese un gráfico de quesitos, el reparto sería algo así:

- Tests de QUIÉN: la parte azul es el factor que generará más diferencias. Son los tests entre el tráfico de AdWords y el de SEO, entre dos segmentaciones de Facebook o dos listas de e-mailings.

- Tests de QUÉ: la parte roja en segunda posición. Testar dos enfoques de USP (calidad versus precio por ejemplo), dos ofertas (un 2x1 contra un -50%) y cosas por el estilo.

- Tests de CÓMO: la parte que a priori tiene menos relevancia. Es la parte creativa y hace referencia a todos los tests de copy (textos) y arte (diseño) que se nos puedan ocurrir.

Empiezas testando a fondo el QUIÉN, luego el QUÉ y sólo al final, el CÓMO

Dentro de cada apartado hay jerarquías a su vez.

Por ejemplo, en el CÓMO no todo es igual de importante. Un test de la cabecera de la landing es mucho más importante que un test de la parte central. Un test de imagen versus vídeo es mucho más importante que un test de tipografías.

Volviendo al ejemplo del principio, un test de color del botón o CTA, es un test de CÓMO, por lo tanto, hay muchas cosas a testar antes en el QUIÉN y en el QUÉ. Pero es que además, dentro de las mil opciones de tests de CÓMO, es uno de los que en principio, tiene menos posibilidades de generar diferencias rentables.

Vaya, que mejor no empezar por el final.

- - - - - - - - - - - - - -

Si quieres mejorar tus resultados digitales, en la agencia CliCo llevamos realizados cientos de A/B testing y en todo tipo de empresas. Solicita ver algunos ejemplos en CliCo, Clicks & Conversions.

Xavi

mayo 25

Hola Gorka,

Un post muy útil.

Te quería hacer una pregunta. Ya sé que me responderás "Cuanto más, mejor", pero quería saber qué considerarías fiable como muestra en cuanto a número. ¿Con 100 podemos extraer conclusiones fidedignas?

Gracias!

Gorka Garmendia

mayo 25

Pues no te voy a responder con un "cuanto más, mejor" 🙂

La muestra fiable debe ser la mínima posible para no gastar recursos pero la suficiente para que los datos sean fiables. Puede ser una muestra de 100 o de 100.000 lo que necesites. No sólo es el tamaño, juega un papel fundamental la diferencia de rendimiento entre A y B. Si A y B son muy diferentes, la muestra podrá ser menor. Si Ay B son muy parecidos, necesitarás más muestra para estar seguros. En internet hay calculadoras y herramientas gratuitas que te ayudan con los cálculos, te paso algunas:

- https://www.optimizely.com/resources/sample-size-calculator/

- https://vwo.com/ab-split-test-duration/

- https://www.perrymarshall.com/splittester/

Álvaro

mayo 26

Muy bueno Gorka. Como siempre, aterrizando la teoría y hablando claro.

El 'problema' de los Test A/B es que no tienen fin. Siempre se puede (debe) testar algo. Las únicas limitaciones son el presupuesto y el tiempo. Incluso si repites una misma campaña en fechas distintas, y tienes datos y conclusiones, seguro que hay variables que puedes introducir para optimizar.

Testar-analizar-optimizar

Gorka Garmendia

mayo 26

Gracias Álvaro!

Así es, pero el lado positivo es que es divertido, adictivo diría yo, y mientras la competencia se pone las pilas tú ya estás muy lejos. Por otro lado es como internet, no puedes dejar de aprender o en un año te quedas desfasado.

Facebook enseñará menos tus posts de empresa y más de amigos o familiares - Gorka Garmendia

enero 29

[…] A/B testing de emailing podemos aprender qué es lo que quiere nuestro cliente y cómo se comporta. Podemos por ejemplo, […]

Utilizar emoticonos en el asunto del emailing ¿sí o no?

noviembre 6

[…] ejemplo de arriba es un test A/B de asunto en el que sólo cambia una cosa: se añade un símbolo, emoji o emoticono al texto del […]